Twitter透露反垃圾信息工具BotMaker技术细节

垃圾信息和僵尸粉是互联网企业面对的共同难题,传统的包括机器学习模型等技术可以对垃圾信息进行识别和分类,但是对于Twitter这样的社交网站来说,对海量垃圾信息进行实时识别却并不是一件容易事。为此Twitter开发出了一个专门的反垃圾系统——BotMaker,上线后将Twitter的垃圾信息立马减少了40%。

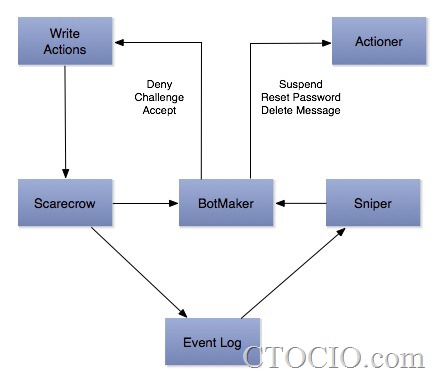

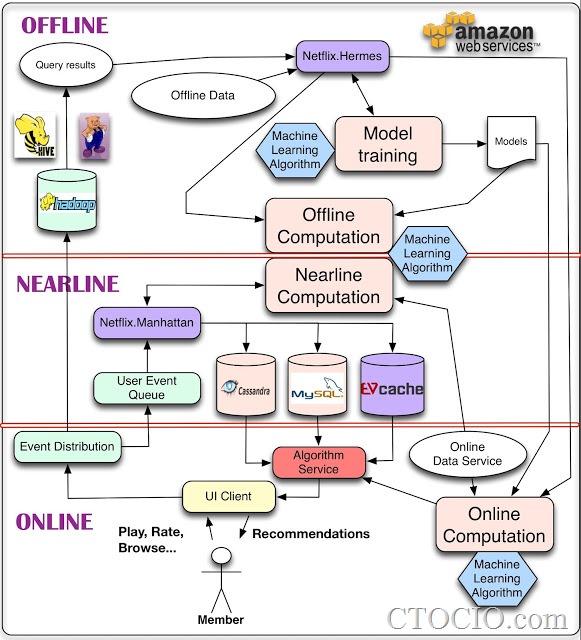

本周Twitter工程师Raghav Jeyaraman在博客中详细介绍了BotMaker技术架构(上图),与很多互联网公司例如Netflix包括Twitter自己的机器学习和数据库架构类似(下图)。但BotMaker则更进一步,将任务分解成一种实时或者接近实时的批任务。其核心是一个名为Scarecrow的工具,能够在垃圾信息写入Twitter数据库之前,通过识别用户名、URL等进行第一道拦截。接下来,一个名为Sniper的工具能够持续扫描清理写入信息,查找那些逃过Scarecrow的漏网之鱼。最后,周期运行的批处理任务能够分析海量离线数据,发现长期的行为模式,并不断完善在线模型。

Netflix的机器学习架构

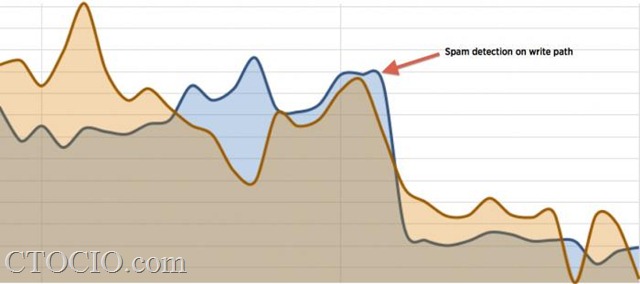

比将Twitter的垃圾信息大幅消减40%更为重要的是,BotMaker的创新技术使Twitter能够在写入路径侦测垃圾信息(下图),而Twitter的工程师们也能够在生产环境中快速添加新的反垃圾规则,而且不影响对延迟高度敏感的实时产品,这对于Twitter甚至整个互联网业界来说意义重大。

据悉,Twitter运用机器学习技术对抗垃圾信息已有多年历史,2012年Twitter联合了加州伯克利大学的研究者开发了能够给予邮件地址等特征过滤能够自动填表的垃圾信息机器人的系统,据当时的一位研究者透露,该技术主要被用于清理Twitter的僵尸粉,但也可以改进后用于在线实时侦测垃圾账户,估计BotMaker的推出与此项研究存在关系。

鉴于Twitter有着开源其优秀工具的美德,我们有理由期待Twitter公司在公布BotMaker技术细节后进一步将其开源。

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: