看脸时代真的到来:人工智能技术识别性取向的准确性超过人类

IT经理网点评:iPhone X引发了“看脸时代”的各种争议和焦虑,但真正让人担忧的确是能够看透面皮的人工智能“相面”技术。最新的人工智能技术(深度神经网络)识别性取向的准确性超过人类,这不禁让人联想到美剧《别对我撒谎》,如果机器能够比人类自己更加了解人类,无疑将引发一场空前的伦理恐慌,这也意味着可被机器取代的人类职业范围扩展到心理咨询师、人力资源、教师、海关稽查等过去认为无法被机器取代的岗位,同时也让人们对防不胜防的人工智能创意项目和大数据失控的化学反应产生担忧。

以下内容由微信号量子位编译整理:

斯坦福大学研究人员Yilun Wang与Michal Kosinski用监督学习算法创造出一种新模型,可以直接从面相判断一个人的性取向,研究论文也即将发表在美国心理学学术月刊《Journal of Personality and Social Psychology》上。

纳尼?!还能根据面相判断性取向?确定我是在看科学期刊而不是误入路边看面相算命的小摊摊?

带着众多问号,我们翻看了实验研究。

01 面相识“同”?

研究人员首先从交友网站的公开信息中收集了14776人的35326张照片,想在照片中提取面部特征。从脸型、嘴型、鼻型、眉形到面部的毛发,这些特征全部被提取并量化。

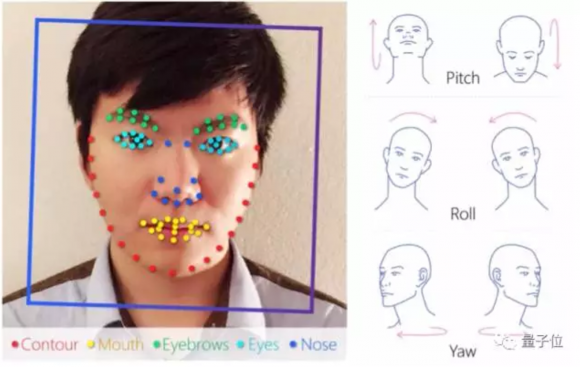

△ 研究人员先标记面部特征,同时用倾斜度、转动和偏转角度等参数定位人脸

之后,研究人员用深度神经网络(DNN)从中提取与性取向有关的特征。在此,他们引入VGG-Face DNN模型,想通过面部表情、背景、光线、图像属性(亮度或对比度等)等因素来表示图像中的人脸。

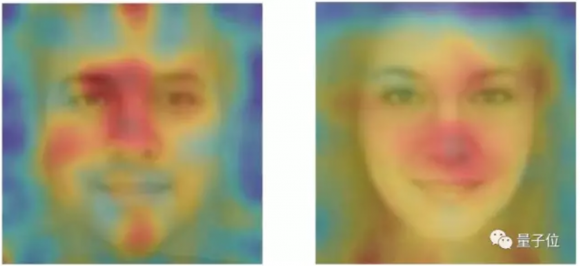

△ 系统识别的可以预测性取向的面部特征

随后,研究人员用预测模型、逻辑回归等奇异值分解(SVD)等方法将图像分类,判断哪些图像中的人为同性恋。

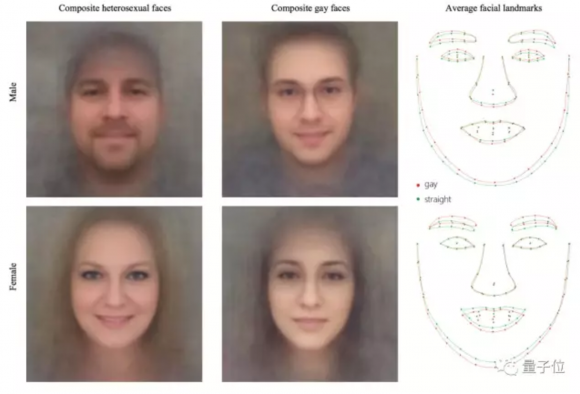

△ 这是由数千张图片组成的合成脸,展示了系统观察到的面部特征细微差别。右图中的绿色/红色线条分别代表男女异性恋者/同性恋者面部器官的位置形状

最后,研究人员随意挑选图像,让电脑猜测受试者的性取向,结果证明AI系统的表现明显优于人类——

在没有穿搭风格、人物动作等因素影响的情况下,就单一面部信息而言,分类器识别男女性取向的准确率分别达到了81%和71%。

研究人员还设计对照组让人类判断照片中人的性取向。实验证明,人类对男女性取向识别准确率分别为61%和54%。对比看来,算法的准确率明显优于人类的直觉判断。

如果通过5张以上照片让系统识别人类性取向,则男女性取向准确率分别提高到91%和83%。

研究人员意外地发现,性取向与面部特征存在些许关联,一般情况下,男同有“女性化”特征,女同有“男性化”特征。比如,男同的下颚、鼻子和前额比直男大,与异性恋女性相比,女同的下颚更大,额头更小。

02 作者简介

这篇论文的作者是Yilun Wang和Michal Kosinski。两个人一起收集了数据并进行分析,论文为Michal Kosinski执笔完成。

量子位经过查询发现,Yilun Wang现在的身份是IDG资本驻旧金山湾区的投资顾问,投资领域专注于AI、机器人、机器学习、计算机视觉等。此前,Yilun曾在Google、百度深度学习研究院、格灵深瞳、微软等公司实习。

Yilun Wang本科毕业于浙江大学,2016年在斯坦福获硕士学位。

而Michal Kosinski博士是斯坦福商学院的助理教授。2014年,Kosinski在剑桥大学获得心理学博士学位。先后供职于微软研究院、剑桥大学,并有过创业经历。

Kosinski还是一位活跃在各种活动和采访中的学者。

今年初的CeBIT’17大会上,Kosinski发表了一场题为《The End of Privacy》(隐私的终结)的演讲。(当然他在别的场合也经常讲这个)

其实Kosinski的这个演讲,跟上面的主题一脉相承。

在《隐私的终结》里,Kosinski指出人们已经在网上留下太多的数字足迹,只需要通过一个强大的算法,把所有这些零散的足迹手机起来,就能描绘出你的真实样貌。

我们本来制作了一个压好字幕的视频,不过两次腾讯都没审核通过。

所以,直接放一个YouTube地址吧:

https://youtu.be/DYhAM34Hhzc

03 各方评论

对于这项研究,部分美国媒体“表示强烈谴责和极大的愤慨”,比如TechCrunch。

他们在标题上指责这项研究“显示了数据时代的黑暗面”,还说这项研究“除了将一个已经很脆弱的人群暴露在新型的系统化虐待之下,还直接打击了我们的平等观念:不能以貌取人、也不能通过一两张照片这么简单的东西来判断性取向这样的隐私。”

英国的《经济学人》情绪稳定,不过《卫报》脑补了一些应用场景,比如怀疑自己形婚了,用这个AI gaydar来测一测自己的另一半,或者青少年用它来测自己、测同学……

《卫报》还”采访了多伦多大学心理学副教授Nick Rule,这位学者曾经研究过gaydar背后的科学,而对于斯坦福的这项研究,他认为非常“令人不安”,担心可能有人出于恶意来“根据人们的外表来分析他们、识别他们”。

reddit上网友的反应就淡定得多,量子位摘录一些网友评论如下:

“所以,他们造了一个Gaydar?”

“Stereotype的存在看来是有原因的”

“好吧……我觉得我还挺擅长通过长相判断谁是同性恋。但如果我说“Joe看起来90%是gay”,是不是不道德?”

“可怕。”

“第一个数据集来自‘一家美国交友网站’。我感觉这说的是OKCupid。”

“我真不明白这有什么可怕的。这个研究可以非常有用,而且不违背道德。”

“我觉得这进一步增强了我们对于性别的认知,我之前不知道面孔中还包含了这么多和性取向有关的信息。”

“很多判断都是基于穿着打扮。如论文中的例子,面部毛发较少常被归为男同(训练数据没包括熊?)戴着棒球帽的常被归为女同。”

“放在交友网站上的照片,可能会包括与性取向有关的隐藏信息。”

“我没看得太仔细,有点疑惑是为什么用预构建和预训练的神经网络,而不是自己训练?他们的确自己训练了,而且表现更好,但他们担心过拟合。我不知道为什么。”

“DNN能够进行纯粹的面部特征分离,不受面部表情、背景、光照、头部方向、图像属性(亮度、对比度)等因素的影响。这能消除图片噪声带来的过拟合风险。”

来源:量子位

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: