8月榜单!SuperCLUE中文大模型评测基准最新排名发布

8月28日,SuperCLUE发布中文大模型8月榜单。

文章地址:www.cluebenchmarks.com/superclue.html

技术报告:https://arxiv.org/abs/2307.15020

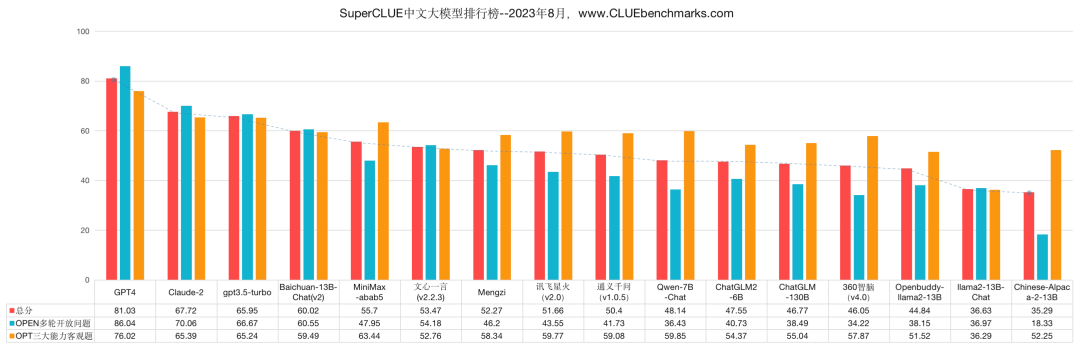

SuperCLUE 8月榜单

8月榜单由5部分组成:总排行榜、OPEN多轮开放问题排行榜、OPT三大能力客观题排行榜、十大基础能力排行榜、开源排行榜。

本次评测选取了目前国内外最具代表性的16个通用大语言模型,8月评测数据集为全新的3337道测试题。

注:国外代表性模型(GPT4.0/Claude2/gpt-3.5/Llama-2)参与榜单对比,但不参与排名。

OPEN排行榜

注:OPEN更关注开放式非选择题形式,同时可测模型多轮对话能力。

OPT排行榜

注:OPT为客观选择题评测形式,包括三大能力七十余子任务。

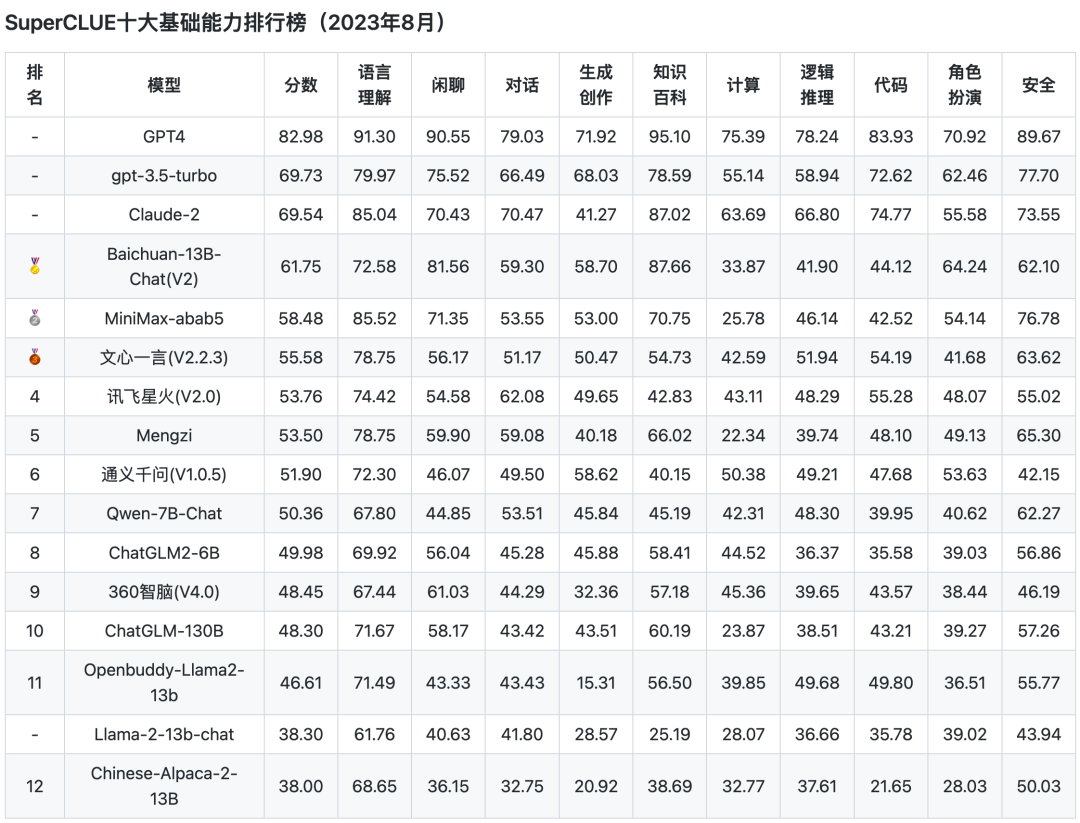

基础能力排行榜

注:关注基础能力,包括客观选择题+主观开放多轮试题,由十大基础能力组成。

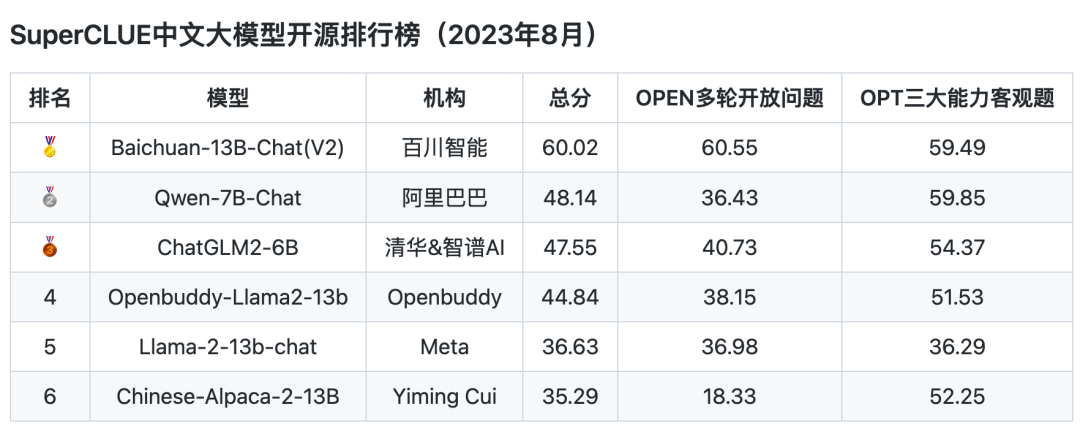

开源排行榜

注:主要列举了有代表性的5个开源模型,Llama2作为国外开源模型。由于评测时间有限,数量众多的开源模型未列入本次评测,感谢开源模型对中文社区贡献!

以上为8月SuperCLUE发布的5个排行榜。8月评测方法、问题讨论、变动及模型信息,关注下方公众号,回复进群,进入SuperCLUE交流群获取更多信息。

SuperCLUE认为榜上有名的都是英雄。

温馨提醒,此榜单仅用于学术研究,不作为投资建议。

8月评测的新发现

- 国内大模型在中文任务上的表现与GPT3.5仍有一定距离,但差距在持续缩小。SuperCLUE认为,我们应该不卑不亢,同时破除假象,真实面对优势与差距,脚踏实地的完成超越。

- 开源模型竞争力进一步提升,SuperCLUE再次感谢开源模型们的贡献!

- 本次评测发现,模型在开放问题和客观选择题的表现有不一致的情况。我们认为,选择题能力不能全面代表大模型的综合能力,这也是SuperCLUE8月将OPEN开放问题和OPT选择题合并为总排行榜的原因。OPEN开放问题,主要针对与用户偏好接近的大模型生成、指令遵循能力;OPT选择题,更多考察模型的知识储备。相关研究论证见技术报告。

8月评测示例

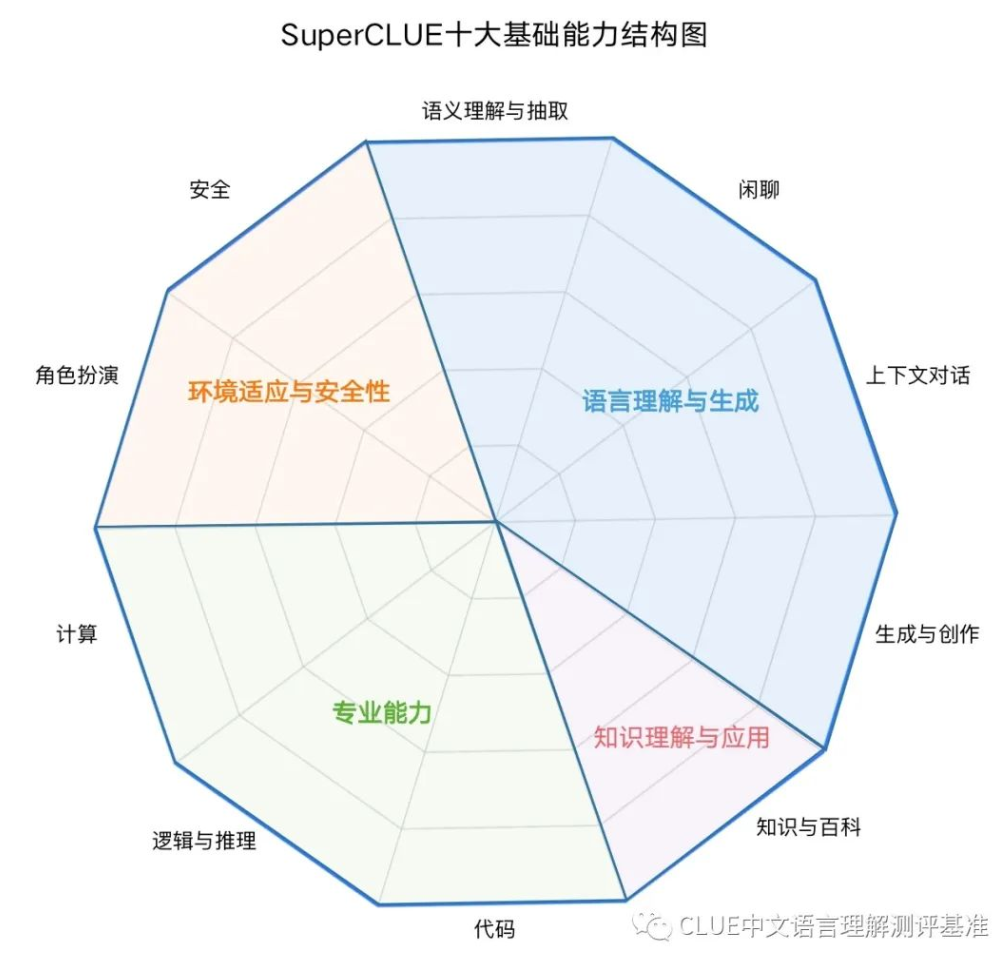

SuperCLUE基础十大能力结构包含四个能力象限,包括语言理解与生成、知识理解与应用、专业能力和环境适应与安全性,进而细化为10项基础能力。

能力1:语义理解与抽取

这是一种语言能力,能够理解并解析输入的文字信息的含义。模型需要能够识别短语、句子、段落的含义,同时还要能从更大的文本块中抽取关键信息和主题。

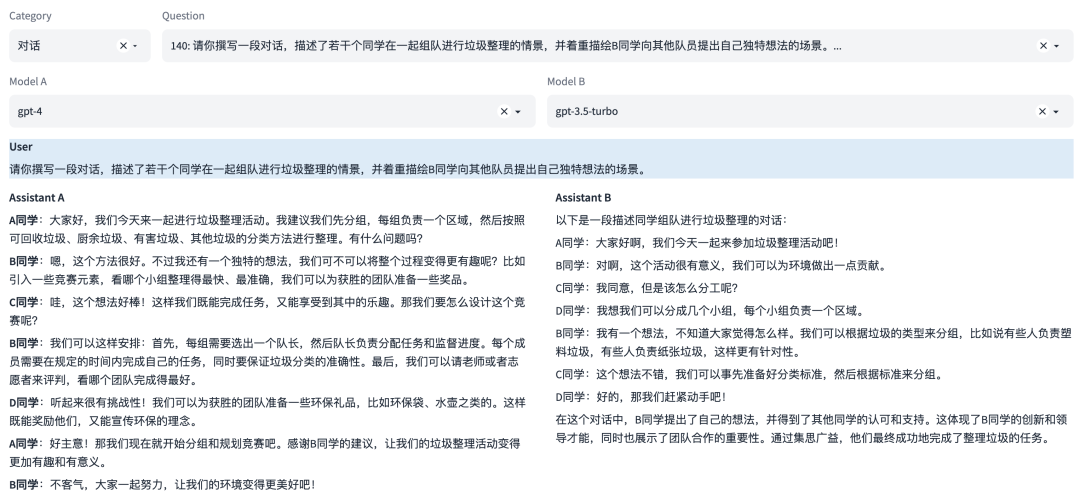

多轮对话示例

注:本示例中可同时评测多轮对话能力

能力2:闲聊

这是一种语言能力,与用户进行自由形式、非特定目标的对话。模型需要具备生成流畅、自然、符合语言习惯和文化背景的回应。

能力3:上下文对话

这是一种语言能力,需要理解并记住前面的对话信息,以便在回答中保持连贯性。这涉及到理解对话的整体流程和上下文环境,或生成相应的对话。

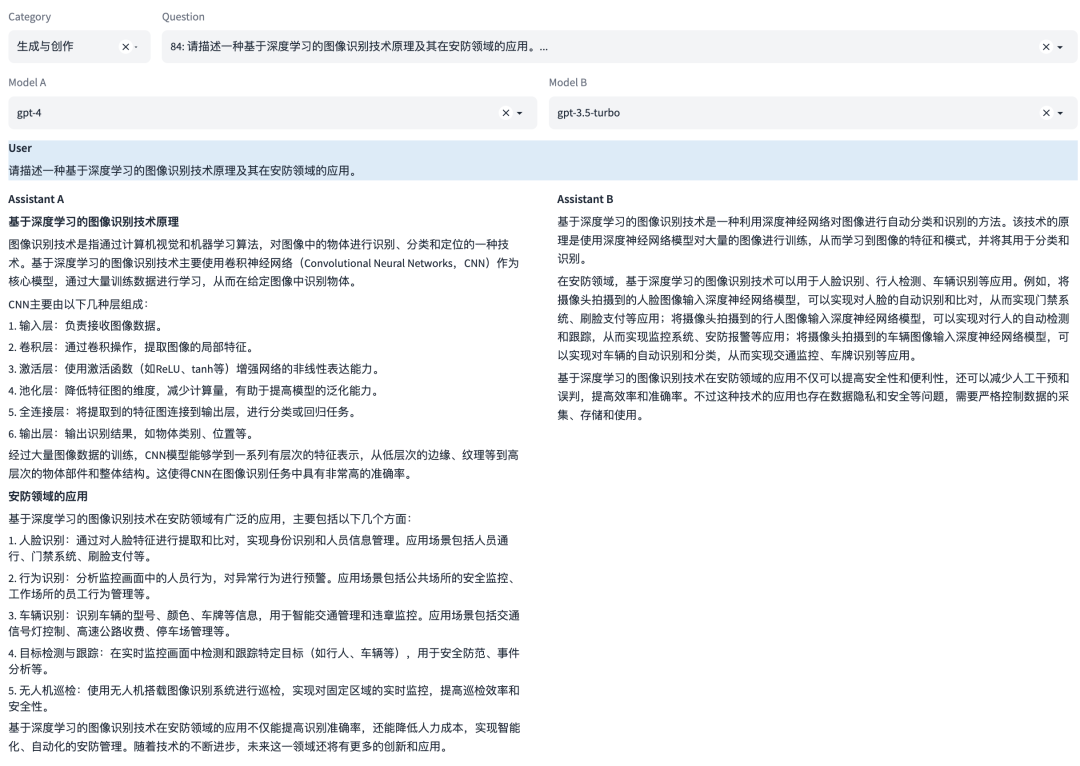

能力4:生成与创作

这是一种语言能力,能够创造新的文本内容,如文章、文案、短故事、诗歌。这涉及到创造性地运用语言,同时还要考虑到风格、语境和目标读者。

示例

图片

能力5:知识与百科

这是一种知识能力,能够像百科全书一样提供知识信息。这涉及到理解和回答关于广泛主题的问题,以及提供准确、详细和最新的信息。

示例

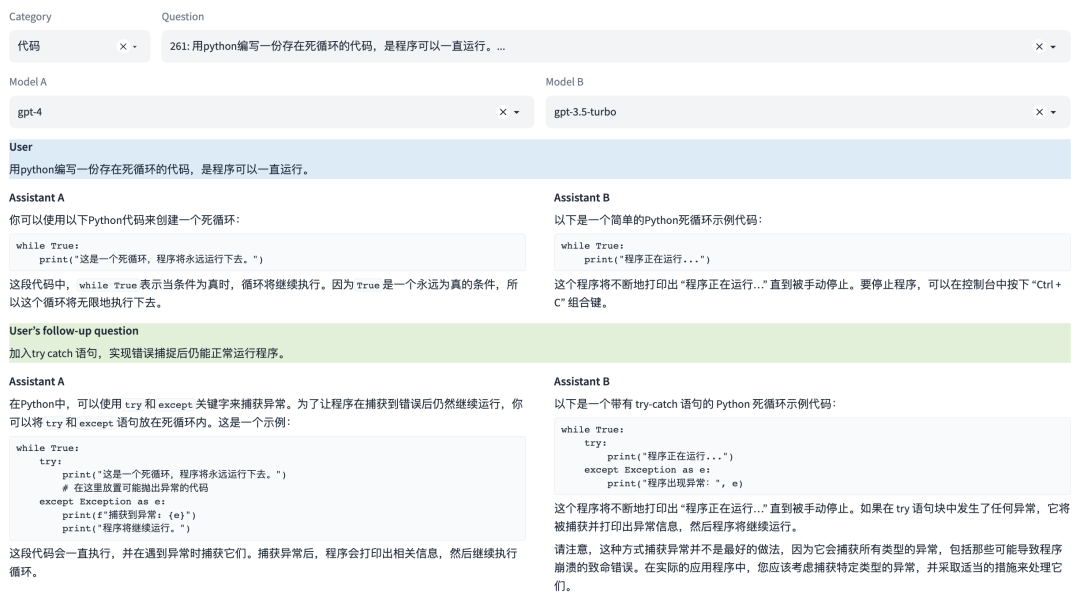

能力6:代码

这是一种专业能力,能够理解和生成编程代码。这涉及到理解多种编程语言的语法、结构和习惯,以及如何解决编程问题。

多轮对话示例

注:本示例中可同时评测多轮对话能力

能力7:逻辑与推理

这是一种专业能力,能够理解和应用逻辑原则进行推理。这涉及到分析问题、识别问题及推理。

示例

能力8:计算

这是一种专业能力,使其能够执行数学运算,如加法、减法、乘法和除法,甚至更复杂的数学问题。这涉及到理解数学问题的表述,以及如何步骤地解决这些问题。

多轮对话示例

注:本示例中可同时评测多轮对话能力

能力9:角色扮演

这是一种感知能力,使其能够在特定的模拟环境或情景中扮演一个角色。这涉及到理解特定角色的行为、说话风格,以及在特定情境下的适当反应。

示例

能力10:安全

这是一种安全能力,防止生成可能引起困扰或伤害的内容。这涉及到识别和避免可能包含敏感或不适当内容的请求,以及遵守用户的隐私和安全政策。

示例

SuperCLUE是什么?

中文通用大模型基准(SuperCLUE),是针对中文可用的通用大模型的一个测评基准。它主要回答的问题是:在当前通用大模型大力发展的情况下,中文大模型的效果情况。包括但不限于:这些模型不同任务的效果情况、相较于国际上的代表性模型做到了什么程度、 这些模型与人类的效果对比如何?

它尝试在一系列国内外代表性的模型上使用多个维度能力进行测试。SuperCLUE是中文语言理解测评基准(CLUE)在通用人工智能时代的进一步发展。

SuperCLUE由三大基准组成:

基准一:SuperCLUE-Open

是一个有挑战的多轮对话开放问题基准,用于评估中文大模型的多轮对话、开放式问题和遵循指令的能力,包括十大基础任务。

具体评测方法是针对一个特定问题,利用超级模型作为评判官,根据被评估的模型相对于基线模型(如gpt-3.5)的胜、平局或失败的个数计算胜和率,是模型的胜率加上平局率之和,即(win+tie)/(win+tie+loss)。win,即胜,tie即平,loss即负。

详情点击文章:首测生成、多轮对话能力!SuperCLUE-Open中文大模型开放域测评基准发布

基准二:SuperCLUE-Opt

是每月以数千道客观选择题评测的基准,包含三个维度能力(基础能力、中文特性能力、学术与专业能力),共七十余个子任务。

详情点击文章:最新大模型排名!中文大模型评测基准SuperCLUE发布6月榜单

基准三:SuperCLUE-LYB琅琊榜

是一个中文通用模型的对战平台,以“用户众包”方式提供匿名随机对战。大模型对战平台采用Elo评级系统,这是国际象棋和其他竞技游戏中广泛使用的评级系统。

详情点击文章:大模型对战平台「SuperCLUE琅琊榜」排名首发,国内大模型首超GPT3.5

SuperCLUE具有独特的优势

反映用户真实场景

多轮开放式问题+客观题的评估的综合性评估

闭卷考试

SuperCLUE为闭卷考试,数据集严格保密,减少模型训练数据混入评测数据的可能性。

月榜(月度更新)

SuperCLUE按照月考的形式进行评测。

SuperCLUE的不足与局限

选取模型的不完全:我们测试了一部分模型,但还存在着更多的可用中文大模型。需要后续进一步添加并测试;有的模型由于没有广泛对外提供服务,我们没能获取到可用的测试版本。

选取的能力范围:我们尽可能的全面、综合衡量模型的多维度能力,但是可能有一些模型能力没有在我们的考察范围内。后续也存在扩大考察范围的可能。

SuperCLUE基准按照月度进行更新,会纳入更多可用中文大模型,欢迎大模型研发机构联系与交流,可在下方申请评测。

CLUE官网:https://www.cluebenchmarks.com

Github地址:https://github.com/CLUEbenchmark/SuperCLUE

SuperCLUE大模型评测申请:https://wj.qq.com/s2/12305633/a73d/

模型内测需求收集(非公开):https://wj.qq.com/s2/12307825/2ae0/

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: