Spark取代MapReduce成为Apache顶级项目

Apache Spark是一种内存数据处理框架,目前已经升级成为Apache的顶级项目,这有助于提高Spark的稳定性,在下一代大数据应用中取代MapReduce的地位。

Spark最近势头很猛,大有取代MapReduce的趋势。本周二Apache软件基金会宣布Spark升级成为顶级项目。

由于性能和速度由于MapReduce,且更加容易使用,Spark目前已经拥有一个庞大的用户和贡献者社区。这意味着Spark更加符合下一代低延迟、实时处理、迭代计算的大数据应用的要求。

Spark的创建者来自加州伯克利大学,目前已经创办了一家名为Databricks的公司推动Spark的商业化。

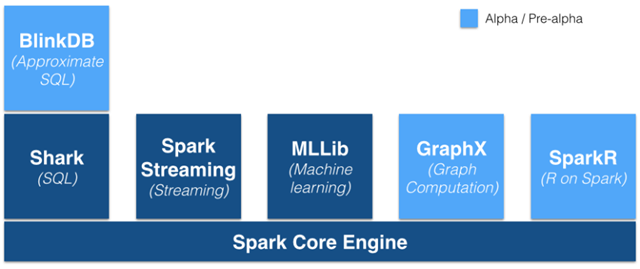

Spark项目的生态环境

从技术上来看,Spark是一个单独的项目,但被设计成能与Hadoop分布式文件系统(HDFS)一起工作,可以直接在HDFS上运行,SIMR使用户无需管理员权限和安装就可MapReduce集群上运行,而且得益于YARN(下一代Hadoop资源规划器和资源管理器),Spark如今能够与MapReduce在同一个集群上运行。Hadoop企业应用先驱Cloudera已经开始向客户提供Spark的企业应用支持。

虽然很多新的项目(例如Hortonworks的Stinger)采用了不同的处理框架,但是MapReduce和Spark还缺少很多工具(例如Pig和Casading),而对于一些特定的批处理任务来说,MapReduce依然是上佳的选择。正如Cloudera联合创始人Mike Olson指出的:MapReduce有大量的遗留工作负载,短时间内不会转移,即使Spark上位。

Via Gigaom

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: