磁盘性能同样彪悍,Spark打破大数据基准测试记录

Apache Spark是当今最火爆的大数据处理框架。Spark的性能和速度都大大优于MapReduce,且更加容易使用,而且Spark已经拥有一个庞大的用户和贡献者社区,这意味着Spark更加符合下一代低延迟、实时处理、迭代计算的大数据应用的要求,大有取代MapReduce的趋势。

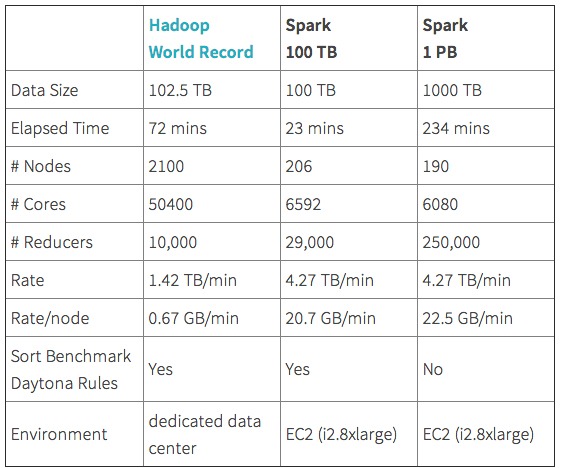

但不少人认为Spark仅仅是在内存计算环境比Mapreduce表现出色。近日为了给Spark正名,Spark商业化公司Databrick在磁盘环境给Spark做了GraySort跑分测试(下图)。

Databrick的Daytona GraySort测试环境使用了亚马逊云中的206台服务器共计6600个内核,测试数据量高达100TB,测试用时仅仅23分钟,打破了此前由雅虎保持的记录,雅虎当时动用了2100节点的Hadoop集群,共计5万多个内核才完成100TB数据的测试(用时72分钟)。

为了展示Spark在可靠处理超大规模数据集方面的性能,Databrick还增加了一个非正式的测试(上图),190台服务器处理1PB数据用时4小时。Databricks的客户营销总监Arsalan Tavakoli表示,不少公司的大数据处理规模远不止1PB,对Spark在生产环境的扩展性持怀疑态度的人,应当看到阿里巴巴的Spark集群已经扩展到数百PB。

Databrick的GraySort基准测试采用HDFS作为存储层,测试数据来自Databricks云,存储在亚马逊的S3或HDFS(AWS实例)。Databrick的官网上周五公布了更多的测试细节,包括测试方法和可信度等。

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: