谷歌开源顶级人工智能自然语言预处理训练技术

自然语言处理(NLP)是人工智能(AI)的子类别,可用于语言翻译、情感分析、语义搜索等许多语言相关任务,但是这说起来容易做起来难。训练NLP文本解析AI系统需要采购大量多源头数据集,对研究人员来说是一项持续的挑战:需要使用最新的深度学习模型,模仿人类大脑中神经元的行为,在数百万甚至数十亿的注释示例中进行训练来持续改进。

当下一种流行的NLP解决方案是预训练,它改进了对未标记文本进行训练的通用语言模型,以执行特定任务。谷歌本周开源来该领域的最前沿技术 – Transformer双向编码器(BERT)。谷歌声称开发人员可以在在云端30分钟内训练“最先进”的NLP模型TPU(谷歌的云托管加速器硬件),在单独的图形处理单元上训练也只需数小时。

目前BERT的最新版本已经发布到Github上,包括预训练的语言表示模型(英文)和构建在TensorFlow机器学习框架之上的源代码。此外,Colab上还有一个相应的笔记本,这是Google为AI开发人员提供的免费云服务。

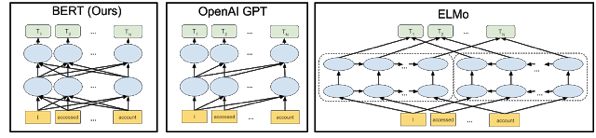

BERT是深度双向、OpenAI GPT是单向、ELMo是浅层双向

正如Google AI的研究科学家Jacob Devlin和Ming-Wei Chang所解释的那样,BERT的独特之处在于它既具有双向性(上图),可以从过去和未来双向访问上下文,并且无人监督,这意味着它可以处理没有分类和标记的数据。这与传统的NLP模型(如word2vec和GloVe)相反,后者为词汇表中的每个单词生成单个无上下文的单词嵌入(单词的数学表示)。

BERT通过预先训练来自任何语料库生成的任务,来学习建模句子之间的关系,Devlin和Chang写道。它建立在Google的Transformer之上,这是一种基于自我关注机制的开源神经网络架构,该机制针对NLP进行了优化。(在去年发表的一篇论文中,谷歌表明,Transformer在英语到德语和英语到法语的翻译基准表现优于传统模式,同时训练需要的计算也更少。)

测试斯坦福问答数据集(SQUAD))——一个阅读理解数据集包含一组维基百科文章提出的问题,BERT达到了93.2%的准确率,击败了此前的最高水平91.6%和人类水平的91.2%。在通用语言理解评估(GLUE)基准测试(用于培训和评估NLP系统的资源集合)上,BERT的准确率也达到80.4%。

BERT的发布前不久谷歌还发布了AdaNet,一个结合机器学习算法以获得更好的预测性分析结果的开源工具,以及调查使用强化学习训练AI代理人进行问答的研究项目ActiveQA 。

获取BERT论文原文请关注IT经理网微信公众号ctociocom,后台回复:BERT

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: