2019人工智能智商测试报告:整体进步巨大,谷歌助理夺魁

无论是智能手机、智能音箱还是车载智能系统,背后都离不开各厂商的人工智能助理技术,虽然此前已经有人工智能助理的语音识别、自然语言处理和翻译能力的横向评测,但是人工智能助理的“智商”却鲜有报告和评测,近日Loup Ventures发布了2019年人工智能数字助理智商测试报告(获取报告原文地址请关注IT经理网微信号ctociocom,后台回复:AI智商报告),对市场主流人工智能助理的智力水平进行横向评测,结果谷歌助理拔得头筹,其他产品则有较大进步。

Loup Ventures的人工智能助理测试包含800个问题,Google智能助理的问题理解率达到100%,答案正确率达到92.9%,比去年的85.5%有较大幅度提高。

相比之下,苹果公司的Siri在两个类别的问题测试中都有所提升,问题理解水平从去年的99%上升到今年的99.8%,答案准确率从去年的78.5%上升到83.1%。换而言之,从用户的角度来看,今年Siri的表现与去年的谷歌助理一样“聪明”。

亚马逊的Alexa再次获得第三名,但今年取得了重大进展,问题理解率达到99.9%,答案正确率达到79.8%比去年的Siri表现更好,相比去年的61.4%有着惊人的提升,这也是该年度报告有记录的最大跃升。

值得注意的是,今年Loup“遗漏”了微软的Cortana,这并不奇怪,因为Cortana已经从微软的产品和第三方配件中消失。Cortana只能正确回答去年问题的52.4%,比抛硬币强不了多少,基本已经从人工智能助理竞赛中出局。

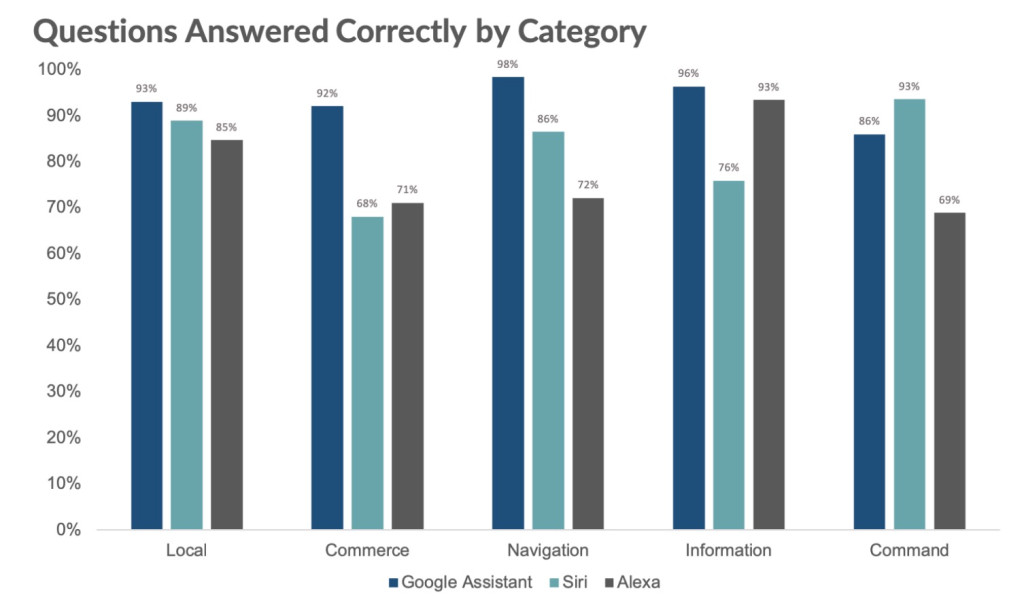

Loup测试涵盖五个不同的类别:“本地”、“商业”、“导航”、“信息”和“命令”,旨在测试AI助理在不同应用场景的表现。

Google智能助理在这五个类别中的四个(除了命令)夺得第一,在商业领域遥遥领先,其92%的准确率超过了Alexa(71%)和Siri(68%)。Siri在命令类别以93%对86%的优势击败了谷歌助理,这也是谷歌助理唯一一次回答正确率降到92%以下。

Alexa在“本地”,“导航”和“命令”类别中排在谷歌助理和Siri这两个主要竞争对手之后,在“商业”方面仅以微弱优势击败Siri。具体测试结果如下:

正如Loup之前提到的那样,人工智能助理的问题理解率向100%迈进是令人印象深刻的,但距离真正的“聪明”还有距离。虽然数字助理能够理解“在合理范围内,你对他们所说的一切”,但他们只是在他们的用例主体中给出很好的回应,但没有表现出更高级别的推理技巧。Loup表示,数字助理的下一步工作是添加“特别适合语音解决”的其他用例,并提供简单易用的用户体验来解决这些问题。

关注微信公众号:CTOCIOCOM 或扫描下方二维码。回复关键词:AI智商报告 。即可获得报告的原文地址。

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: