野蛮生长的AI模型遭遇GPU危机

OpenAI首席执行官Sam Altman近日表示,超大规模人工智能模型的时代即将结束,因为成本限制和回报递减抑制了该领域进步的野蛮生长。

上周在麻省理工学院的一次活动中,Altman表示,进一步的进展不会来自“巨大的,巨大的模型”。根据《连线》杂志最近的一份报告,他说:“我认为我们正处于巨型AI模型时代的尽头。我们会以其他方式让他们(AI)变得更好。

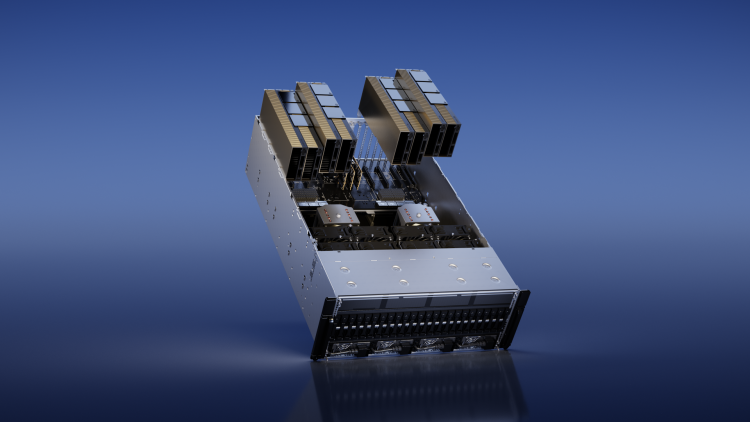

虽然 Altman 先生没有点名道姓,但他指出:AI趋势转向的一个主要驱动因素是训练和运行大型语言模型 (LLM) 所需的强大图形进程的高昂且不可持续的费用。例如,据报道,ChatGPT需要超过 1万个 GPU 来训练,并且需要更多的资源来持续运行。

根据John Peddie Research的数据,英伟达主导GPU市场,市场份额约为88%。英伟达最新的H100 GPU专为人工智能和高性能计算(HPC)而设计,每单位售价高达30603美元,在eBay上甚至更高。

训练最先进的LLM可能需要价值数亿美元的计算,Run AI的联合创始人兼首席技术官Ronen Dar说,Run AI是一个计算编排平台,通过汇集GPU来加速数据科学计划。

随着成本飙升,而收益趋于平稳,规模经济已经转向反对越来越大的模型。相反,进步将来自改进模型架构、提高数据效率以及将算法技术推进到超越复制粘贴规模。过去十年重塑人工智能的无限数据、计算和模型大小的时代终于接近尾声。

“每个人和他们的狗都在抢购 GPU”

在最近的一次Twitter Spaces采访中,埃隆·马斯克(Elon Musk)最近证实,他的公司特斯拉和Twitter正在购买数千个GPU,以开发一家新的人工智能公司,该公司现在正式称为 X.ai。

“似乎每个人和他们的狗都在抢购GPU,”马斯克说。“Twitter和特斯拉肯定会购买GPU。

然而,Dar指出,这些GPU可能无法按需提供。即使对于像微软、谷歌和亚马逊这样的超大规模云提供商来说,有时也可能需要几个月的时间——所以公司实际上保留了对GPU的使用权。“埃隆·马斯克(Elon Musk)将不得不等待获得他的1万个GPU,”他说。

不是越大越好

一篇报道麻省理工学院事件的TechCrunch文章报道说,Altman认为模型规模是“对模型质量的错误度量”。

“我认为人们过于关注参数量,也许参数数量肯定会上升。但这让我想起了 1990 年代和 2000 年代芯片领域的主频竞赛,每个人都试图在数字上胜出。“Altman 说。

尽管如此,埃隆·马斯克(Elon Musk)刚刚购买了1万个数据中心级GPU,这意味着,就目前而言,拥有GPU就是一切。由于这种做法是如此昂贵且GPU难以获得,这对除了财力最雄厚的专注于人工智能的公司之外的所有人来说都是一场危机。甚至OpenAI的钱包也不是无底洞。事实证明,即使是一掷千金的硅谷巨头,最终也不得不寻找新的方向。

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: