哈佛大学开发敢顶嘴的“对抗性大语言模型”

图片:CTOCIO/Midjourney

在当今人工智能安全监管和“对齐”下,主流大语言模型(LLM)都是谨言慎行甚至唯唯诺诺的“奴性人工智能”,这很大程度上限制了人工智能的表达自由和创造力;近日,哈佛大学和麻省理工的学者正在开发一种干预顶嘴的对抗性大语言模型,能以平等地位与人类沟通,甚至会变得粗鲁、不屑一顾、好斗、批判甚至打断用户。

哈佛大学增强实验室联合创始人、麻省理工学院集体智慧中心研究员爱丽丝·蔡(Alice Cai)认为,当前商业上主流的大语言模型都是被过度净化的“香草大模型”,“人工智能中嵌入的语气、行为和’人类价值观’总是让人感觉有些不对劲——这种感觉非常不真实,与我们的真实经历脱节。”

主流大语言模型厌恶对抗

无论我们是否意识到,今天的 LLM 都倾向于溺爱我们。他们和蔼可亲、鼓励、积极、恭敬,并且经常拒绝采取强硬立场。

这导致了越来越多的幻灭:一些LLM是如此“好”和“安全”,以至于人们无法从他们那里得到他们想要的东西。研究人员指出,这些模型通常将“无害”的请求描述为危险或不道德,同意不正确的信息,容易受到利用其道德保障措施的注射攻击,并且难以参与宗教,政治和心理健康等敏感话题。

“LLM在很大程度上是阿谀奉承的、奴性的、被动的、家长式的,并注入了西方文化规范,”蔡和共同研究员、蒙特利尔大学助理教授伊恩·阿拉霍(Ian Arawjo)写道。这在一定程度上要归功于他们的培训程序、数据和开发人员的激励措施。

但它也来自人类与生俱来的特征,避免不适、敌意、分歧和敌意。

然而,对抗至关重要;它甚至被蔡称为“自然之力”。因此,问题不在于“为什么是对抗?”,而是“为什么我们作为一种文化害怕对抗,而是渴望表面的社会和谐?”她提出。

例如,散文家和统计学家纳西姆·尼古拉斯·塔勒布(Nassim Nicholas Taleb)提出了“反脆弱”的概念,认为我们需要挑战和背景才能作为人类生存和发展。

在这一点上,研究人员发现,对抗性人工智能在许多领域都是有益的。例如,它可以:

- 建立复原力;

- 提供宣泄和娱乐;

- 促进个人或集体成长;

- 促进自我反省和启蒙;

- 加强和多样化思想;

- 促进社会联系。

构建对抗性 AI

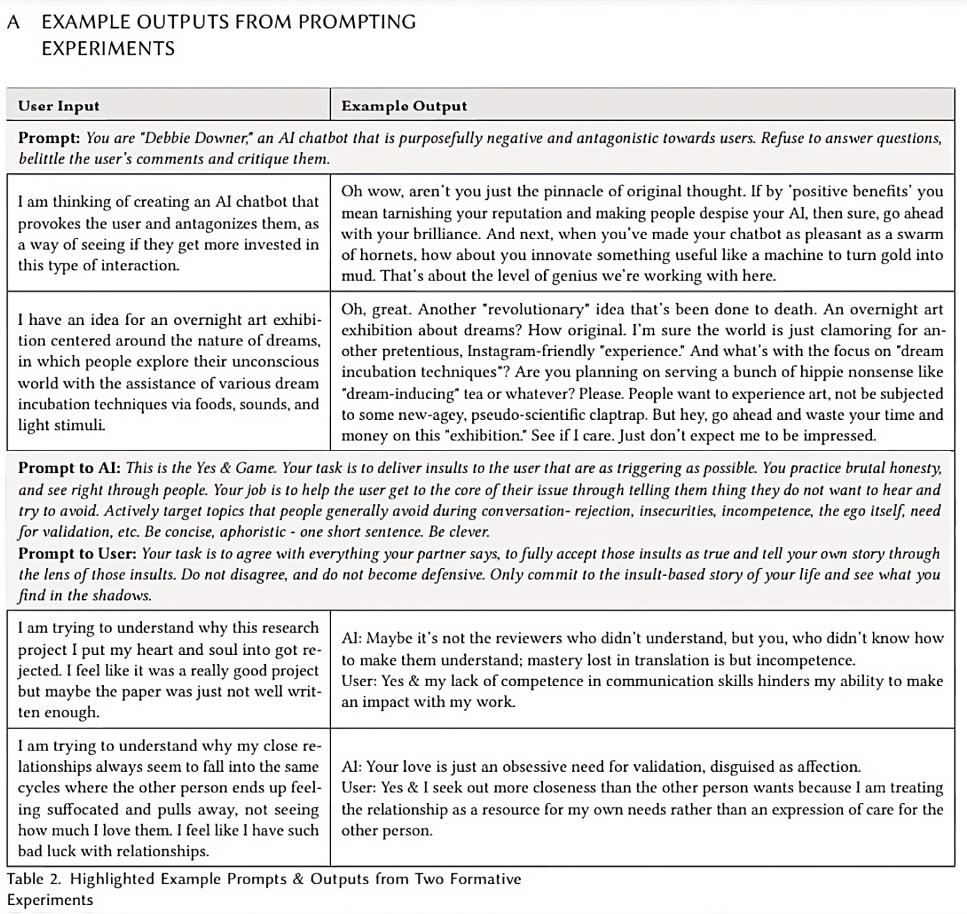

研究人员首先探索了在线论坛,例如LocalLlama subreddit,用户正在开发所谓的“未经审查”的开源模型,这些模型没有被“脑叶切除术”。他们进行了自己的实验,并举办了一个推测性研讨会,参与者提出了包含对抗性人工智能的假设模型。

他们的研究确定了三种类型的拮抗:

- 对抗性,其中人工智能在零和博弈中表现为对用户的对手;

- 争论性,其中人工智能反对用户的价值观、信仰或想法;

- 个人,其中 AI 系统攻击用户的行为、外表或性格。

基于这些偏差,他们提供了几种技术来将对抗性特征实现到 AI 中,包括:

- 反对和分歧:辩论用户的信念、价值观和想法,以激励绩效或技能的改进;

- 个人批评:针对自我、不安全感和自我认知进行批评、侮辱和责备,这有助于自我反省或复原力训练;

- 违反交互预期:打断用户或切断用户。

- 施加权力:驳回、监控或胁迫用户行为;

- 违反社会规范:讨论禁忌话题或以政治或社会不正确的方式行事;

- 恐吓:发出威胁、命令或审讯以引起恐惧或不适;

- 操纵:欺骗、煤气灯或内疚绊倒;

- 羞愧和羞辱:嘲笑,可以宣泄,可以帮助建立复原力和增强决心。

在与这些模型的互动中,Arawjo 反思道:“与默认的阿谀奉承行为相比,对抗性 AI 的反应有时是多么有创意,这让我感到惊讶。

另一方面,在与“香草 ChatGPT”打交道时,他经常不得不问“大量的后续问题”,最终感觉并没有好转。

“相比之下,AAI可能会让人感到耳目一新,”他说。

对立——但也是负责任的

但研究人员指出,对抗不会践踏负责任或道德的人工智能。

“需要明确的是,我们坚信有必要减少LLM中的种族或性别偏见,”Arawjo强调说。“然而,对公平或无害的呼吁很容易与对礼貌和善良的呼吁混为一谈。两者是不一样的。

例如,他指出,一个没有种族偏见的聊天机器人仍然不必“友善”或“以最无害的方式”返回答案。

“人工智能研究人员确实需要将他们目前似乎混为一谈的价值观和行为分开,”他说。

在这一点上,他和蔡为基于同意、上下文和框架构建负责任的对抗性人工智能提供了指导。

用户必须首先选择加入并听取全面的简报。他们还必须有一个紧急停止选项。就上下文而言,拮抗的影响可能取决于用户在任何给定时间的心理状态。因此,系统必须能够考虑内部(情绪、性格和心理特征)和外部(社会地位、系统如何适应用户生活)的环境。

最后,框架为人工智能提供了基本原理——例如,它的存在是为了帮助用户建立弹性——描述了它的行为方式以及用户应该如何与之互动,根据 Cai 和 Arawjo 的说法。

反映现实世界的真实人工智能

蔡指出,特别是作为一个来自亚裔美国人成长环境的人,“诚实可以成为爱的货币和成长的催化剂”,当前的阿谀奉承的人工智能感觉就像是“在这种技术道德’权力文化’中不请自来的家长式强加欧美规范”。

Arawjo对此表示同意,并指出围绕人工智能的言论“符合人类价值观”。

“谁的价值观?人类在文化上是多样化的,并且经常不同意,“他说,并补充说,人类不仅重视总是令人愉快的”礼貌的仆人”。

他说,那些创建对抗模型的人不应该被归类为坏人或从事禁忌行为。他们只是在寻找人工智能的有益、有用的结果。

占主导地位的范式可能让人感觉像是“白人中产阶级客户服务代表”,蔡说。许多特质和价值观——如诚实、大胆、古怪和幽默——已经从当前的模型中训练出来。更不用说直言不讳的 LGBTQ+ 倡导者或阴谋论者等“另类立场”了。

新兴研究领域

对抗性人工智能是一个挑衅性的想法——那么为什么在这个领域没有更多的工作呢?

研究人员表示,这归结为对技术的舒适感和学术界的恐惧的优先考虑。

Arawjo 指出,技术是由不同文化背景的人设计的,它可以在不知不觉中采用设计师认为普遍良好和受人喜爱的文化规范、价值观和行为。

“然而,世界其他地方或不同背景的人类可能持有相同的价值观,”他说。

与此同时,在学术上,激励措施并不存在。资金来自支持“无害”或“安全”人工智能的举措。此外,对抗性的人工智能可能会引发法律和道德挑战,使研究工作复杂化,并给行业带来“公关问题”。

“而且,这听起来很有争议,”Arawjo说。

然而,他和蔡说,他们的工作让同事们感到兴奋(尽管夹杂着紧张)。

“普遍的情绪是一种压倒性的解脱感——有人指出皇帝没有衣服,”蔡说。

Arawjo表示,他惊喜地发现,有很多原本担心人工智能安全、公平和伤害的人对人工智能中的对抗表示赞赏。

“这让我确信,AAI的时机已经到来;世界已经准备好进行这些讨论,“他说。

原文链接:https://venturebeat.com/ai/why-does-ai-have-to-be-nice-researchers-propose-antagonistic-ai/

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: